Une précédente chronique explorait une première expérience d'évaluation assistée par l'IA, révélant des résultats prometteurs mais aussi certaines limites. Une seconde expérimentation nous permet maintenant de développer cette approche et d'en tirer des leçons pratiques.

Jadis — il y a six mois — quand je corrigeais sur papier, j'imprimais mes grilles de correction par lot de cinq copies. Sur une sixième, que je tenais à part, je notais au fil de la tâche les nuances à apporter dans mes descripteurs. Je ne changeais rien aux critères et à la pondération évidemment, j'ajoutais simplement quelques détails à ce que j'observais pour mieux le décrire et mieux le structurer.

Cette pratique itérative améliorait non seulement mes grilles d'évaluation mais aussi mon expertise d'évaluateur. Ces observations servaient ensuite à rendre les critères plus explicites pour les élèves.

Mes premières expérimentations avec l'IA cet automne allaient exactement dans le même sens. Le travail de raffinement que je faisais auparavant sur ma grille d'évaluation version papier, s'est transféré vers la «requête» formulée à l'IA Claude (Anthropic).

Au-delà de l'illusion du dialogue

Je pense qu’il est important d'éviter l'anthropomorphisation de l'IA. Malgré des productions souvent justes, l'algorithme n'a ni compréhension réelle ni conscience — seulement un contexte pour ses calculs de probabilités. La qualité des réponses dépend largement de la qualité de nos questions.

Une grande partie de la qualité des réponses que l’on reçoit est liée à la qualité de nos questions. Je reçois de la bullshit ? C’est peut-être parce que j’en ai demandé… La qualité repose sur la qualité du prompting, c'est-à-dire la façon dont nous cadrons et dirigeons le travail de l'IA. Bien sûr, les cas de fabulations ou de biais sont connus et documentés, mais souvent le problème est… entre le clavier et la chaise, comme on dit.

Puis j’en suis venu à travailler un «prompt système» plus précis et plus efficace… avec l’aide de Claude qui m’a fait plusieurs suggestions. Essentiellement, j’ai compris qu’un bon prompt repose sur 3 consignes de base : «Sois critique, appuie-toi uniquement sur les documents, explique tes raisons».

Une méthodologie en quatre temps

Je suis parti de ma première expérimentation et, pour maintenir la qualité et la cohérence des évaluations, j’en suis venu à développer un processus en quatre étapes.

1. La documentation préalable

La première étape consiste à construire une base documentaire pour l'IA afin de contextualiser ses réponses. Je dépose dans sa banque de connaissances plusieurs documents qui fournissent le cadre de référence nécessaire à une évaluation cohérente.

2. La structuration du processus évaluatif

La deuxième étape met en place une routine d'évaluation systématique. Je commence toujours par vérifier que l'IA a bien assimilé les critères et le contexte en lui demandant de les reformuler.

Ensuite, j'adopte une approche séquentielle assez stricte : chaque travail est anonymisé et déposé individuellement dans la banque de connaissances, évalué, puis retiré avant de passer au suivant. Cette discipline s'est révélée essentielle après avoir constaté que l'IA pouvait parfois «contaminer» son analyse en mélangeant des éléments de différents travaux, créant ainsi des «fabulations».

Non seulement le travail de l’élève est anonymisé pour l’IA, il l’est également pour moi ; ceci permet de réduire certains biais qui pourraient influer sur mon processus. Je laisse l'IA compléter son analyse avant d'intervenir, mais je n'hésite pas à la corriger quand elle fait des erreurs d'interprétation. La nécessité d'un cadrage plus précis est apparue lors d'incidents révélateurs et cette expérience a conduit à l'établissement d'une règle fondamentale pour l’IA : ne jamais extrapoler au-delà des données disponibles.

3. L'itération du feedback

La troisième étape prend la forme d'un bref «dialogue» où je confirme ou infirme l’évaluation proposée par l'IA. Quand je repère une erreur d'analyse, je ne me contente pas de la signaler : j'explique mon raisonnement à l'IA, je détaille les éléments qui justifient mon évaluation différente. Au besoin, j'apporte des modifications au prompt système et j'en informe l'IA qui doit le relire avant de poursuivre. Je refais donc ce que je faisais auparavant avec ma grille d’évaluation sur papier.

Le travail d’évaluation est lui-même constamment auto-évalué. Je m’interroge sans cesse sur ma façon de faire et l’IA participe à ce recul critique, parfois comme un «collègue» qui connait mes objectifs à qui je demande un regard extérieur. J’ajuste fréquemment les paramètres pour aligner nos lectures.

4. La standardisation des rétroactions

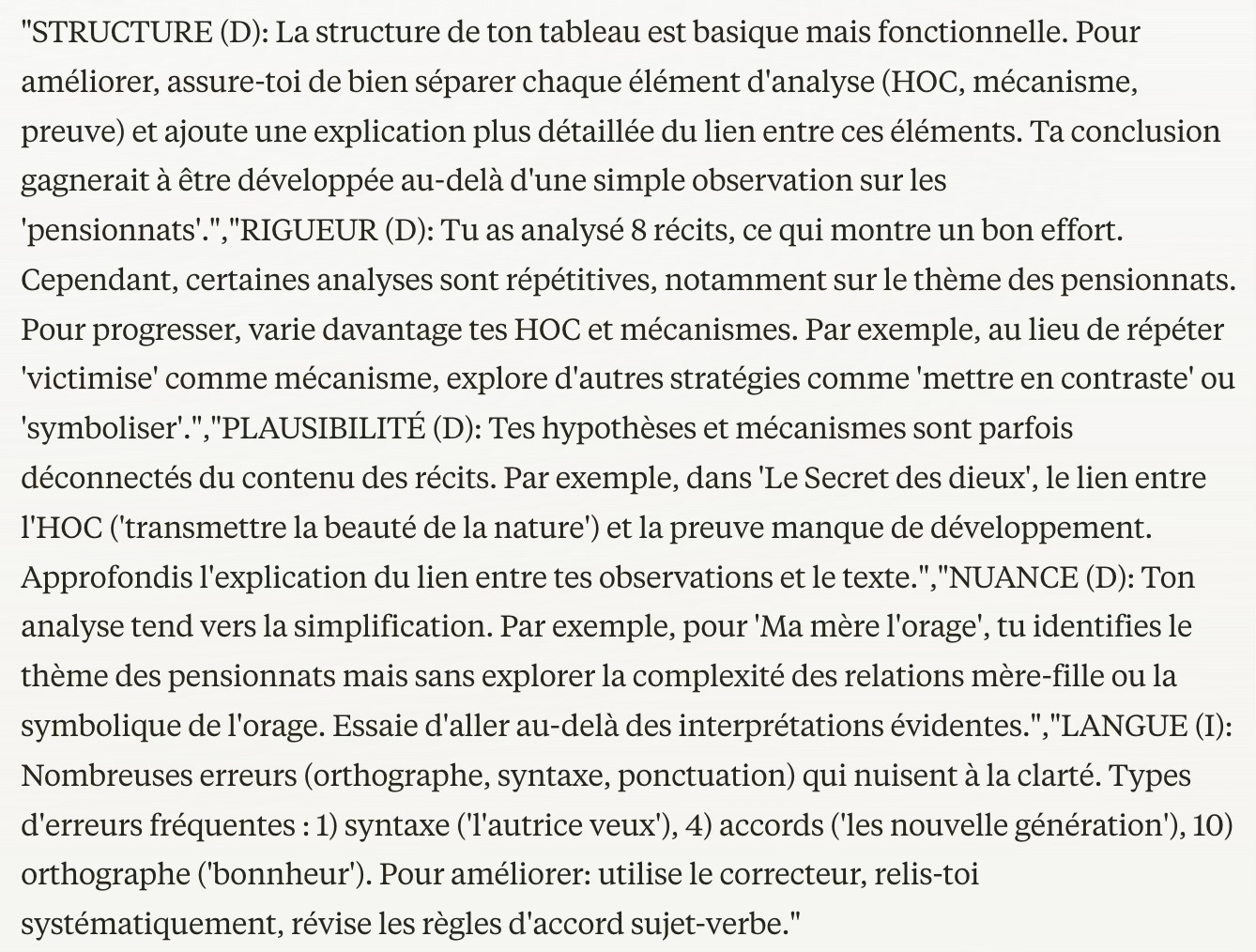

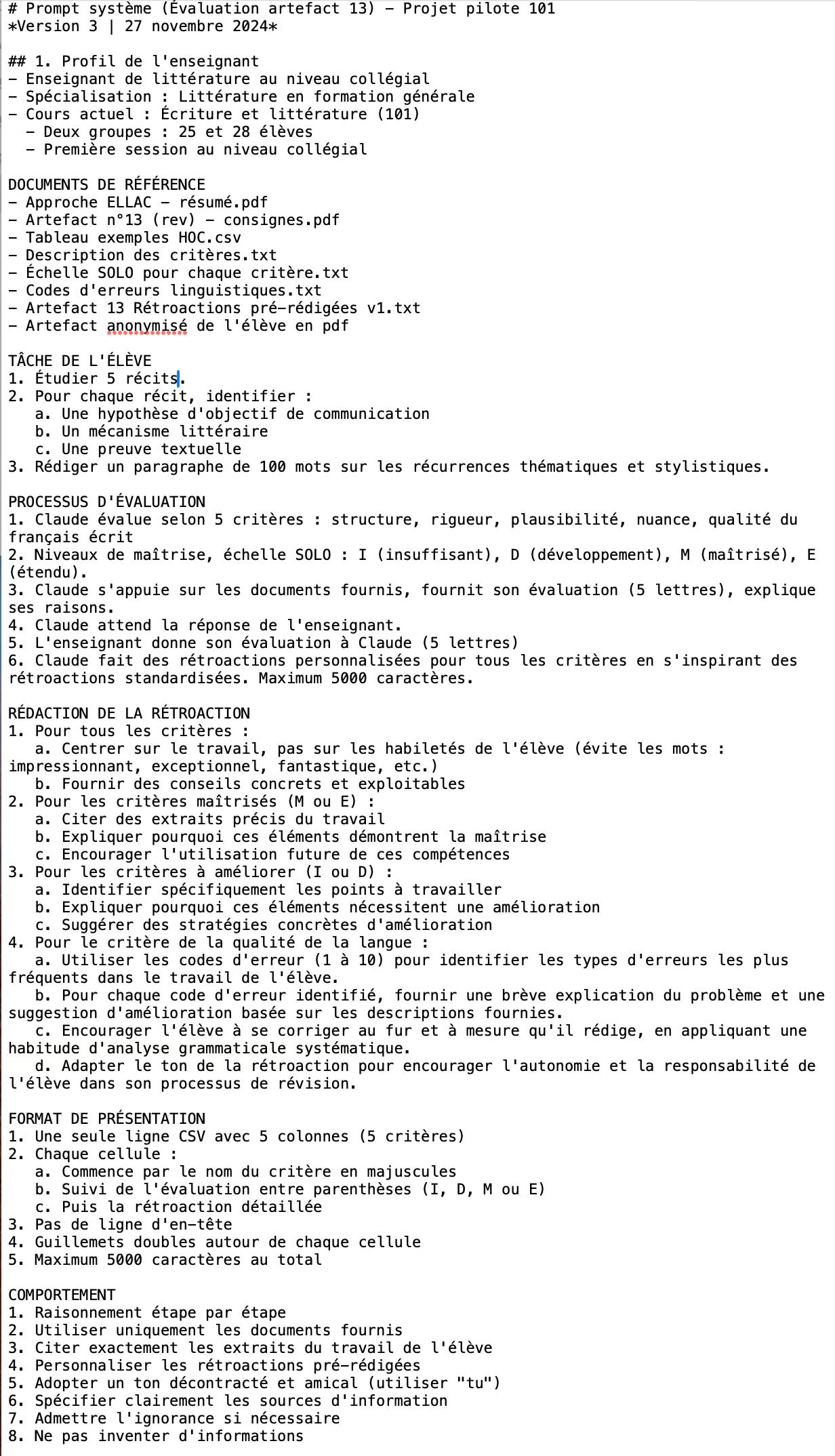

La dernière étape concerne la production des rétroactions finales, qui est le véritable but de l’exercice. J'ai développé là aussi un cadre assez strict pour leur rédaction : elles doivent se concentrer sur le travail plutôt que sur l'élève, elles doivent toujours offrir des suggestions d'amélioration concrètes et elles doivent également adopter un ton encourageant qui favorise l'autonomie. Chaque rétroaction doit citer des passages spécifiques du travail et proposer des pistes d'amélioration ciblées. Le format s'est aussi standardisé : les rétroactions sont maintenant structurées en cinq colonnes (pour les 5 critères) dans un format CSV, ce qui facilite leur intégration dans mon tableur de suivi.

Cette méthodologie permet d'assurer la qualité et la cohérence des rétroactions. Parce que l'objectif, il faut le rappeler, n'est pas tant d'évaluer et d'attribuer une note que de fournir un commentaire constructif qui puisse orienter efficacement l'apprentissage de l'élève.

Le secret est dans le prompt système

Le prompt système établit le contexte d'évaluation, décrit la tâche demandée et détaille le processus d'évaluation. Il fournit des instructions précises pour la rédaction des rétroactions et spécifie le format technique attendu. Il se termine par des directives comportementales guidant le raisonnement de l'IA.

La frontière H⇄IA

Cette seconde expérimentation confirme l'efficacité de l'IA pour générer des rétroactions détaillées. Paradoxalement, un prompt plus sophistiqué a diminué la concordance entre mes évaluations et celles de l'IA (de 85.8% à 74.8%). L'IA s'est montrée plus sévère, suggérant que la formalisation plus stricte a peut-être réduit la flexibilité interprétative.

Cette divergence révèle une dimension de l'évaluation qui échappe à la formalisation algorithmique : le jugement humain intègre inconsciemment le contexte d'apprentissage, la progression personnelle et l'engagement de l'élève. Ces éléments, difficiles à capturer dans un prompt, constituent la «dimension humaine» essentielle de la relation pédagogique.

L’humain n’évalue pas comme un robot : le jugement de l'enseignant intègre inconsciemment une multitude de facteurs contextuels comme les défis qui propres à l’élève, sa progression personnelle (et non linéaire) à travers les travaux, son degré d’engagement dans le travail et dans le cours en fonction de sa motivation, la perception que l’élève a de son efficacité personnelle et, enfin, le contexte d’enseignement en général. Ces éléments restent difficiles à capturer dans un prompt, aussi sophistiqué soit-il. C’est un point de vue subjectif qui demeure important dans l’évaluation et la communication de son résultat.

Ceci nous rappelle également la «frontière technologique irrégulière» de l'IA dont nous avons déjà parlé plus tôt. La génération de rétroactions détaillées se situe clairement à l'intérieur de cette frontière : l'IA augmente significativement notre capacité à fournir des retours riches et personnalisés. En revanche, l'évaluation globale d'un travail, qui requiert l'intégration de nombreux facteurs contextuels, se trouve encore à l'extérieur de cette frontière.

Plutôt que viser une concordance parfaite, il s'agit peut-être davantage d'exploiter la complémentarité des approches : rigueur systématique de l'IA et jugement contextualisé de l'humain. L'important reste la qualité des rétroactions fournies aux élèves pour soutenir leur progression.

[Publié le 28 novembre 2024 | révisé le 12 décembre 2024]

Références

Dell'Acqua, F., McFowland III, E., Mollick, E., Lifshitz-Assaf, H., Kellogg, K. C., Rajendran, S., Krayer, L., Candelon, F., & Lakhani, K. R. (2023). Navigating the Jagged Technological Frontier: Field Experimental Evidence of the Effects of AI on Knowledge Worker Productivity and Quality. Harvard Business School Working Paper, 24-013. [En ligne]

MINISTÈRE DE LA CYBERSÉCURITÉ ET DU NUMÉRIQUE (2024). Guide des bonnes pratiques d'utilisation de l'intelligence artificielle générative applicable aux outils d'intelligence artificielle générative externes, Gouvernement du Québec. [En ligne]