Les enseignant.es peu familiers avec l'intelligence artificielle générative tendent à la voir comme une menace à l'intégrité académique. Pourtant, l'expérimentation révèle une réalité plus nuancée, comme le soulignent Bowen et Watson :

Réduire la tricherie est une bonne chose, mais nous devons aussi repenser nos standards, ce que nous espérons vraiment enseigner, et ce que signifiera l'intégrité académique dans cette nouvelle ère. 1

Bowen et Watson, Teaching with AI

Ethan Mollick, dans Co-Intelligence : Living and working with AI, propose quatre principes fondamentaux :

Toujours inviter l'IA à la table

Être l'humain dans la boucle

Traiter l'IA comme une personne, mais lui dire quel type de personne elle est

Supposer que c'est la pire IA que vous utiliserez jamais

Ces principes offrent un cadre pratique pour intégrer l'IA dans le travail tout en maintenant le rôle essentiel de l'humain.

Premiers pas

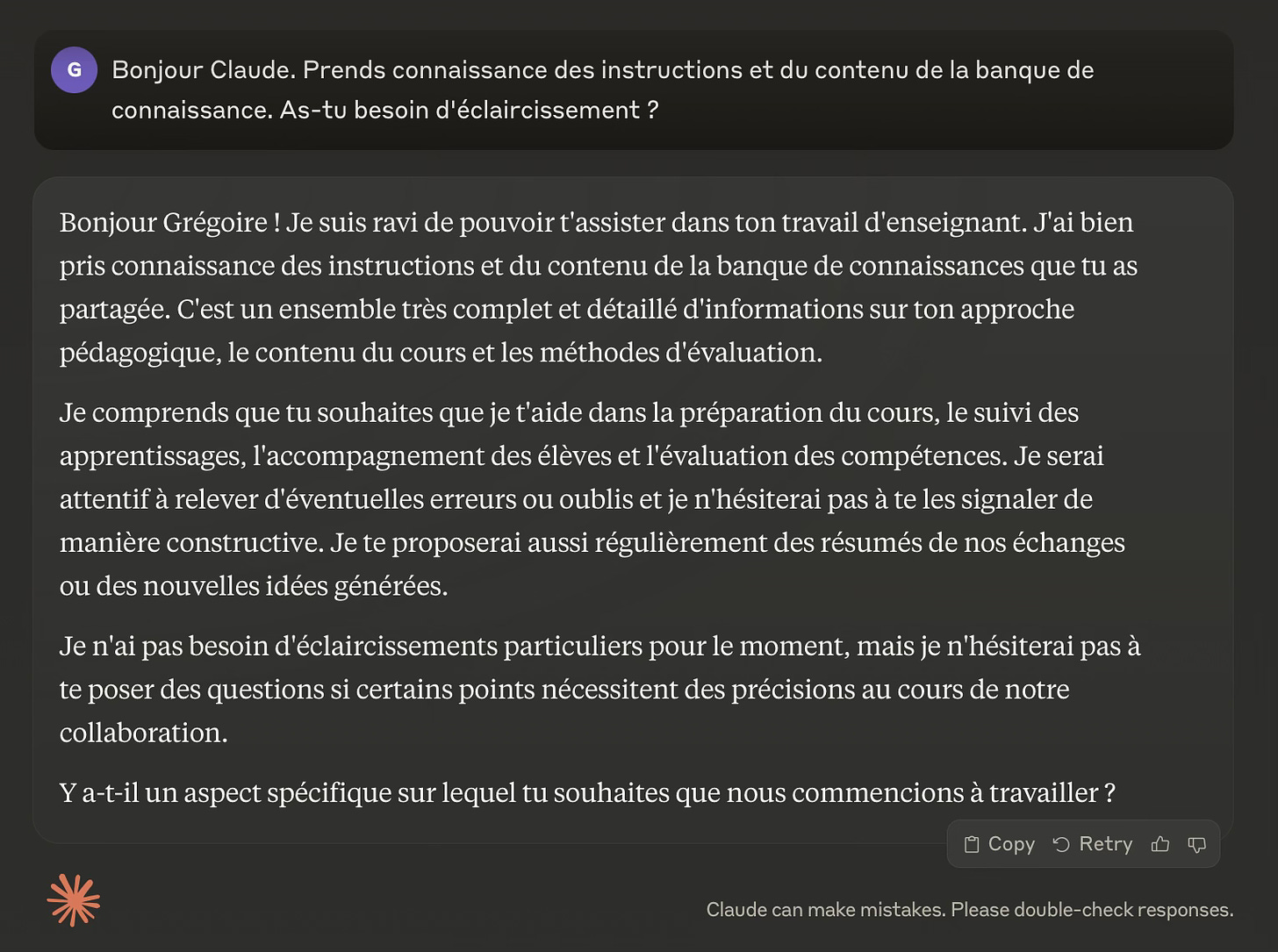

Mon expérience avec l'IA a débuté lors de la préparation du cours Écriture et littérature, que je devais donner avec peu de préavis. Face au défi d'intégrer une nouvelle approche (ELLAC) et d'explorer des œuvres récentes, j'ai fait appel à l'IA pour m'aider dans l'analyse préliminaire. D'abord avec ChatGPT, puis avec Gemini qui offrait des analyses plus nuancées. Ces outils m'ont permis d'identifier rapidement les thèmes et les potentielles hypothèses de communication.

L'arrivée de Claude au Canada en juin 2024 a marqué un tournant. Sa maîtrise du français et sa capacité à comprendre des demandes complexes m'ont convaincu d'adopter le plan professionnel. Cette collaboration a transformé ma façon de travailler.

L'intégration de l'IA dans l'éducation n'est pas une possibilité future — c'est notre réalité actuelle. Ce changement exige plus qu'une acceptation passive ou une résistance futile. Il nécessite une réinvention fondamentale de la façon dont nous enseignons, apprenons et évaluons les connaissances. À mesure que l'IA devient partie intégrante du paysage éducatif, notre attention doit évoluer. L'objectif n'est pas de surpasser l'IA ou de prétendre qu'elle n'existe pas, mais d'exploiter son potentiel pour améliorer l'éducation tout en atténuant ses inconvénients. La question n'est plus de savoir si l'IA va changer l'éducation, mais comment nous allons façonner ce changement pour créer un environnement d'apprentissage plus efficace, équitable et engageant pour tous.

Ethan Mollick, Post-apocalyptic education 2

Quelques critères de sélection pour une collaboration plus poussée

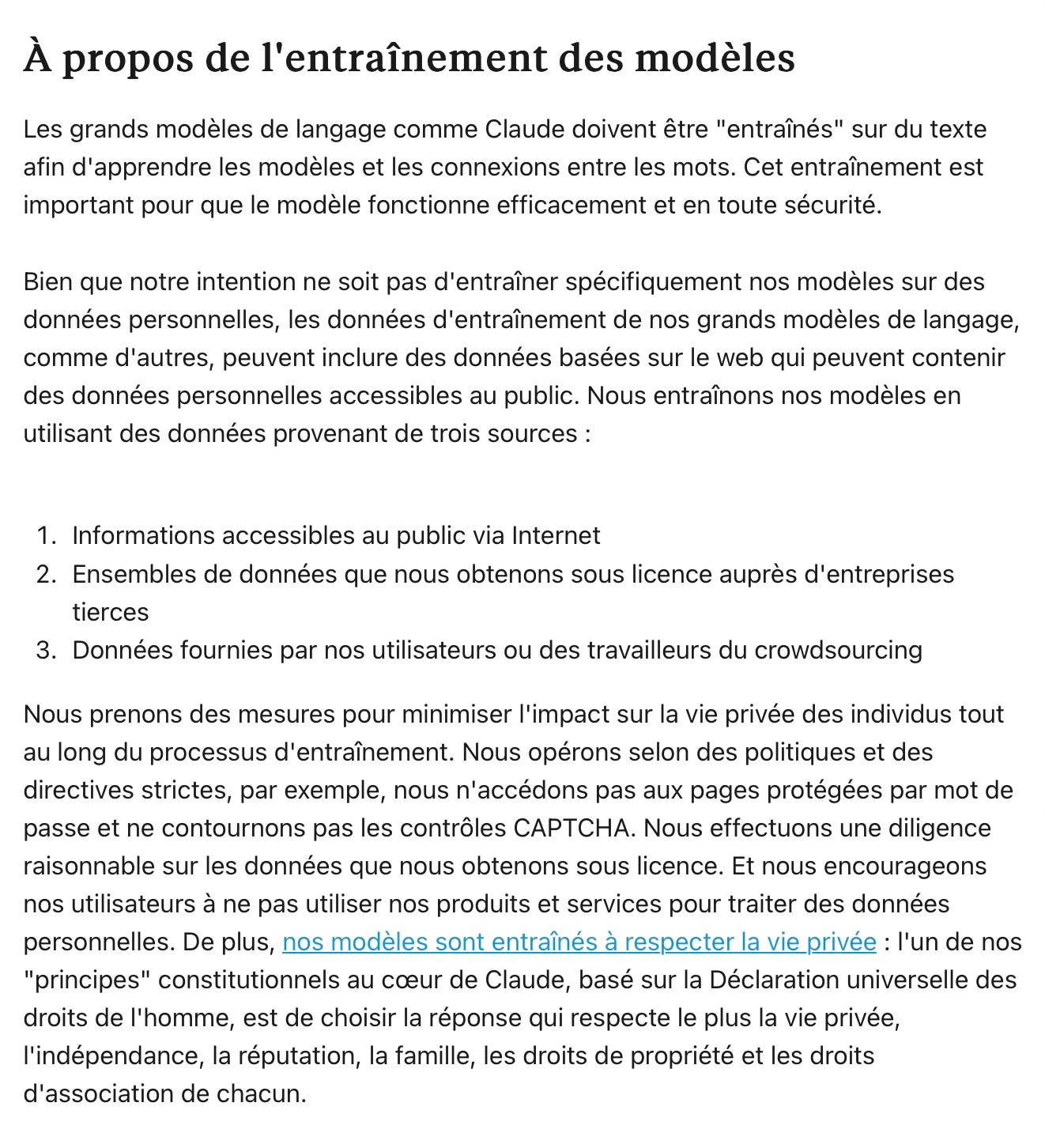

Le choix de Claude reposait sur plusieurs facteurs : la sécurité des informations, l'éthique de l'entraînement des données, et surtout ses capacités en analyse textuelle et en élaboration de stratégies pédagogiques.

Je ne voulais pas travailler avec ChatGPT et je m’éloignais progressivement de Gemini pour des raisons de sécurité des informations et aussi pour des raisons éthiques liées à la nature des données qui ont servi à entrainer les deux LLM. Non seulement l’IA constitutionnelle de Claude répondait à mes préoccupations, mais, contrairement à OpenAI et Google, Anthropic indiquait ne pas utiliser les entrées ou sorties des IA pour entraîner ses modèles. L’entreprise entrainait ses modèles en utilisant des données provenant de trois sources : les informations disponibles sur Internet, des données obtenues sous licence et enfin des données fournies par le crowdsourcing. 3

Ces atouts ont considérablement augmenté mon efficacité dans la création de matériel pédagogique.

J’ai donc commencé à expérimenter de nouvelles pratiques avec, derrière moi, un infatigable assistant boosté aux stéroïdes. Cependant, comme toute IA, Claude reste un généraliste : il m'est arrivé de devoir écarter certaines suggestions (basées par exemple sur des neuromythes) ou refuser des fabulations. Ceci illustre bien le principe 4 de Mollick : c'est la pire IA que vous utiliserez jamais.

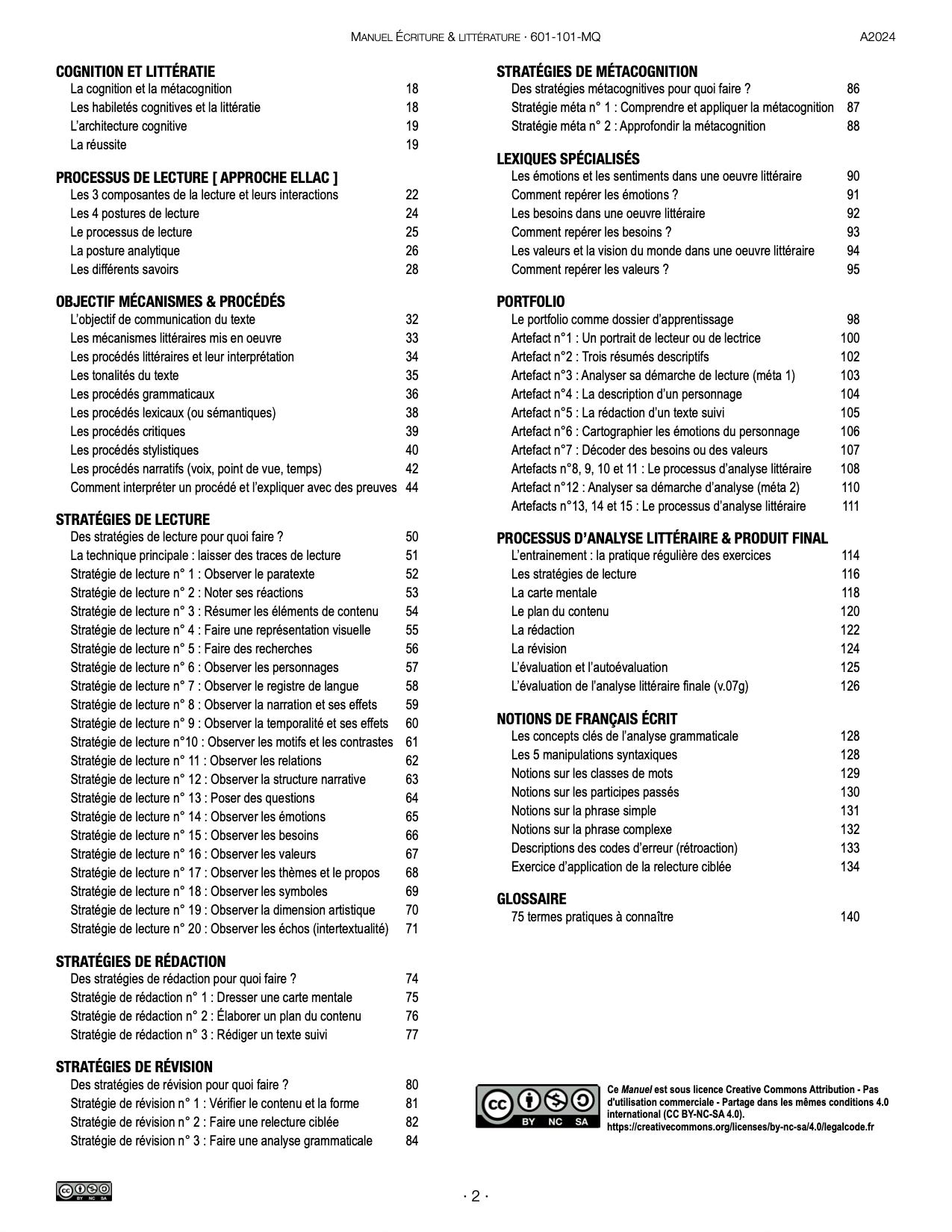

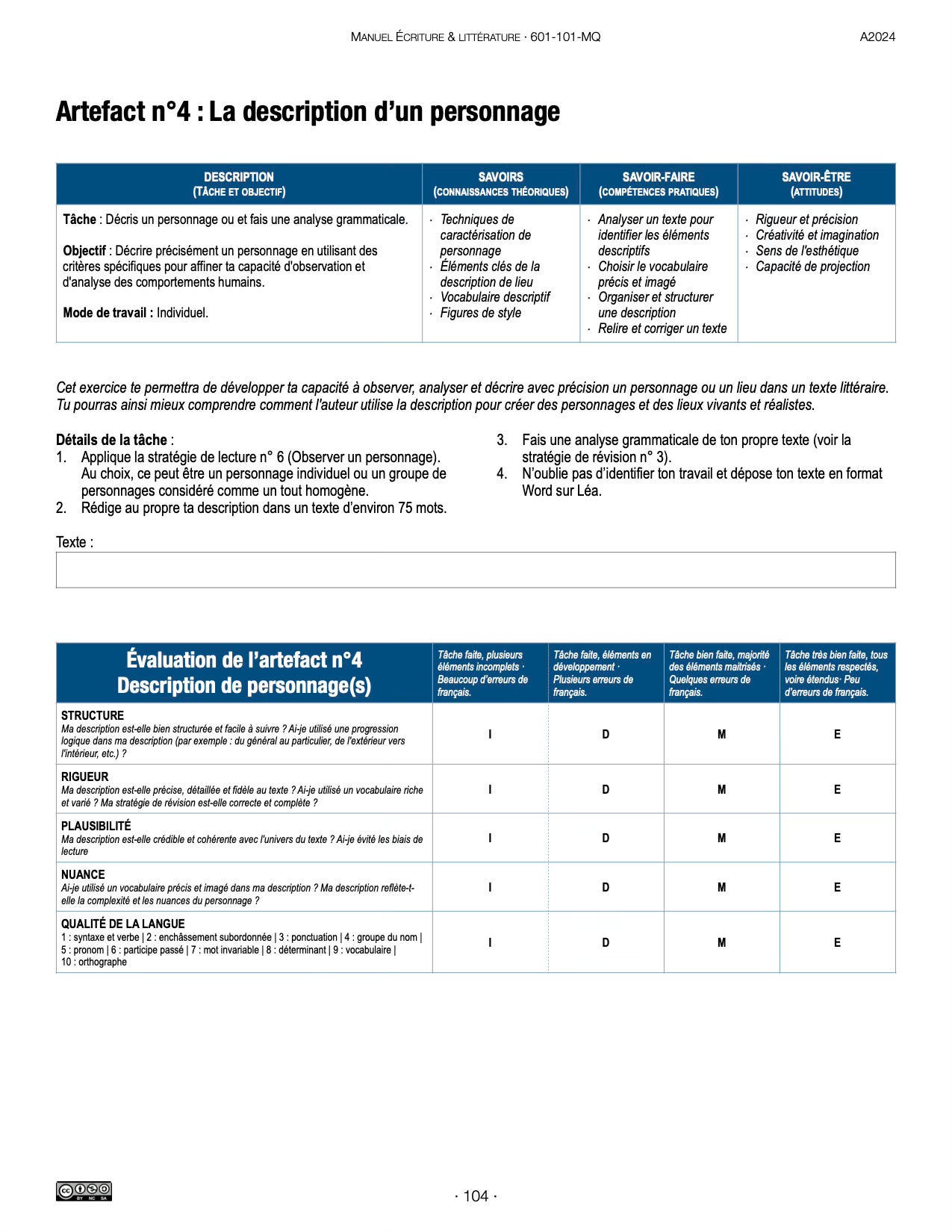

Mais, somme toute, Le résultat est assez impressionnant. J’ai produit en trois semaines un Manuel assez complet du cours Écriture et littérature de près de 145 pages.

Définir les limites : ce que l'IA peut et ne peut pas faire

Cette expérience de l’IA au travail s'inscrit dans un phénomène plus large, bien documenté par une étude récente intitulée Navigating the Jagged Technological Frontier 4. Cette recherche met en lumière ce que les auteurs appellent la « frontière technologique irrégulière » de l'IA, où certaines tâches sont facilement réalisées par l'IA, tandis que d'autres, apparemment similaires, restent hors de sa portée. Les chercheurs réalisent que «les professionnels qui naviguent habilement sur cette frontière obtiennent d'importants avantages en termes de productivité lorsqu'ils travaillent avec l'IA, tandis que l'IA peut en fait diminuer les performances lorsqu'elle est utilisée pour un travail en dehors de la frontière».

L'étude de Dell'Acqua et al. (2023), menée auprès de 444 professionnels pendant 6 mois, démontre que l'IA peut augmenter significativement la productivité (+25%) et la qualité du travail (+40%). Dans le domaine spécifique de l'écriture, Noy et Zhang (2023) observent une réduction du temps d'exécution de 40% et une amélioration qualitative de 18%. Plus intéressant encore : l'IA tend à niveler les écarts de performance entre utilisateurs. Ces résultats, bien qu'obtenus dans des contextes contrôlés, rejoignent mon expérience de juin 2024 : la création aussi rapide de mon manuel n'aurait pas été possible sans l'IA.

L'article Navigating the Jagged Technological Frontier rappelle cependant l'importance de rester vigilant quant aux limites de l'IA, en particulier pour les tâches situées en dehors de sa frontière de compétences. On peut comprendre par exemple que certains aspects de l'enseignement, comme l'évaluation fine des compétences des étudiants ou la réponse en temps réel à leurs besoins restent fermement dans le domaine humain. Ces observations rejoignent les conclusions de l'étude sur l'importance de la complémentarité entre l'humain et l'IA.

Deux modèles de collaboration humain-IA

L'article Navigating identifie deux approches de collaboration avec l'IA. Le modèle Centaure implique une alternance stratégique entre tâches IA et humaines - comme un cavalier guidant sa monture. Le modèle Cyborg, lui, représente une intégration plus profonde où humain et IA travaillent en symbiose constante.

Dans ma pratique, j'adopte ces deux postures selon le contexte : Cyborg pour la création de matériel pédagogique, Centaure pour l'enseignement où mon expertise guide l'utilisation des outils IA. Cette frontière H⇄IA, bien qu'irrégulière, est essentielle à maintenir : elle permet d'exploiter la puissance de l'IA tout en préservant le contrôle pédagogique.

L'IA peut augmenter l’efficacité de l’enseignant·e, mais il faut rappeler que c'est sa compétence professionnelle qui guide l'ensemble du contenu et des interventions, de la conception jusqu’à la mise en œuvre. L’enseignant·e est l’acteur ou l’actrice principal·e quand il ou elle peut justifier et expliquer chacun des choix pédagogiques qu’il ou elle fait. Sans ces compétences, on risque de simplement reproduire du contenu généré par l'IA sans réelle valeur ajoutée, si ce n’est pas du contenu tout simplement faux ou erroné (mais apparemment plausible). N’est-ce pas ce que l’on pourrait reprocher à des élèves qui délègueraient leurs travaux aux chatbots?

Cette expérimentation avec l'IA m'a amené à repenser fondamentalement mon approche de l'enseignement de la littérature, où l'analyse devient un prétexte pour développer le processus réflexif.

Dans la prochaine chronique, nous explorerons comment l'IA pourrait éventuellement devenir un partenaire de rédaction.

[Publié le 15 octobre 2024 | révisé le 14 décembre 2024]

Bowen, J. A., & Watson, C. E. (2024). Teaching with AI: A Practical Guide to a New Era of Human Learning. Johns Hopkins University Press. (p. 133)

Mollick, E. (2024). Post-Apocalyptic Education. Substack. 30 août 2024 [En ligne]

Mollick, E. (2024). Co-Intelligence : Living and working with AI. Penguin Random House.

Anthropic (2024). Comment utilisez-vous les données personnelles dans l'entraînement des modèles ? [En ligne] Consulté le 10 octobre 2024.

Dell'Acqua, F., McFowland III, E., Mollick, E., Lifshitz-Assaf, H., Kellogg, K. C., Rajendran, S., Krayer, L., Candelon, F., & Lakhani, K. R. (2023). Navigating the Jagged Technological Frontier: Field Experimental Evidence of the Effects of AI on Knowledge Worker Productivity and Quality. Harvard Business School Working Paper, 24-013. [En ligne]