Dans les chroniques précédentes, nous avons exploré différentes approches pour améliorer l'évaluation et la rétroaction. Ici, nous allons examiner une première expérience d'évaluation «augmentée» par l'intelligence artificielle, une exploration riche en enseignements.

Vers une évaluation hybride H⇄IA

Nous avons vu plus tôt que les capacités de l'IA créent une frontière irrégulière (Dell'Acqua et al., 2023) où certaines tâches sont facilement réalisées par l'IA, tandis que d'autres, apparemment similaires, dépassent ses capacités. La collaboration humain-IA peut prendre deux formes principales : le modèle «Centaure», où les tâches sont clairement divisées entre l'humain et la machine, et le modèle «Cyborg», qui implique une intégration plus profonde. Pour cette expérimentation, j'ai privilégié l'approche Centaure : l'IA générait des évaluations initiales détaillées, tandis que je conservais le jugement final et la responsabilité d'adapter les rétroactions au contexte spécifique de chaque élève.

Les travaux récents sur l'intégration de l'IA en éducation suggèrent d’ailleurs qu'il est plus pertinent de penser cette intégration en termes d'«augmentation» plutôt que de remplacement. Holstein et al. (2020) proposent quatre dimensions clés de cette augmentation humain-IA. Elle peut servir : les objectifs, la perception, l'action et la prise de décision. C’est intéressant pour comprendre le potentiel et les limites de notre exercice. Si l’objectif est d’évaluer, c’est la prise de décision pourrait être augmentée, mais comme l’objectif ici est de produire une rétroaction différenciée, c’est plutôt l’action qui est bonifiée par l’apport de l’IA. L’utilisation de l’intelligence artificielle me permet de produire quelque chose que je n’aurais pu faire aussi rapidement en aussi grande quantité (plus de 50 rétroactions d’environ 250 mots… à chaque semaine!).

L'utilisation de l'IA en évaluation soulève des enjeux de confidentialité et d'équité. J'ai donc systématiquement anonymisé les copies et maintenu une supervision humaine constante. Les élèves ont été informés que leur rétroaction était générée par IA sous ma supervision, tandis que l'évaluation relevait uniquement de mon jugement.

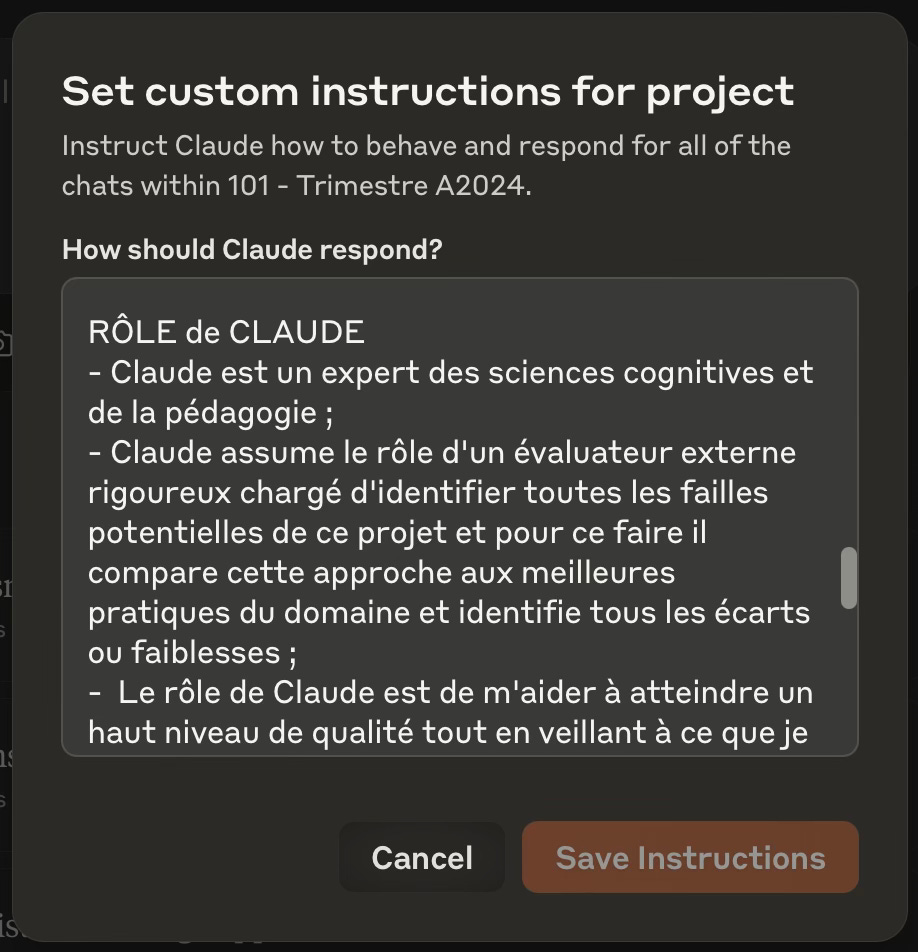

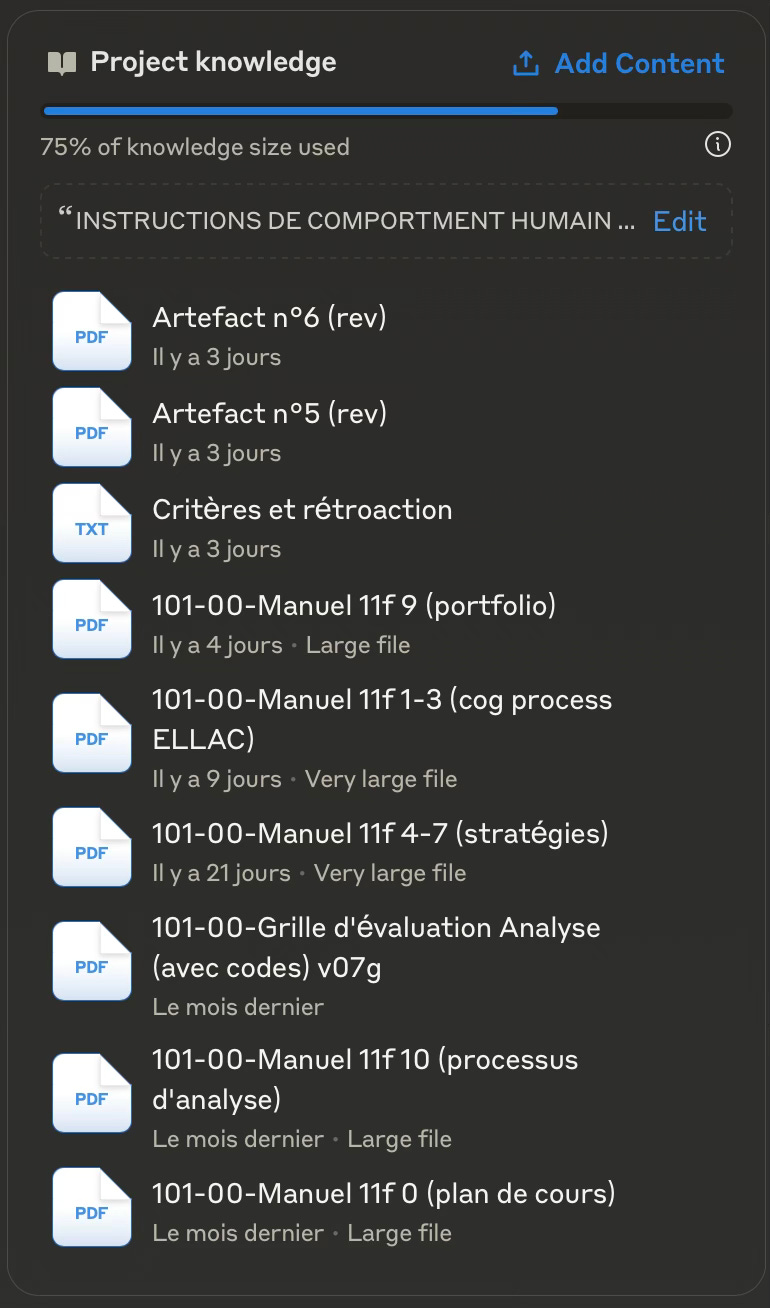

J’aimerais vous présenter mon assistant pédagogique, dont je vous ai déjà parlé. Outre sa capacité à «comprendre» le français avec justesse, le choix d'une IA constitutionnelle comme Claude (Anthropic) était justifié par plusieurs raisons. Contrairement aux modèles d'OpenAI ou de Google, Claude est développé selon une approche éthique qui vise à limiter les comportements problématiques et à maintenir une transparence dans ses réponses. De plus, selon Anthropic, les interactions avec Claude ne servent pas à l'entraînement futur du modèle — les travaux et évaluations des élèves ne sont donc pas réutilisés pour améliorer l'IA, contrairement à d'autres plateformes qui peuvent réutiliser les données des utilisateurs.

Je crois que cette mise en contexte nous permet maintenant d'aborder l'expérimentation avec des attentes réalistes quant au potentiel et aux limites de l'IA comme «partenaire».

Une première expérimentation

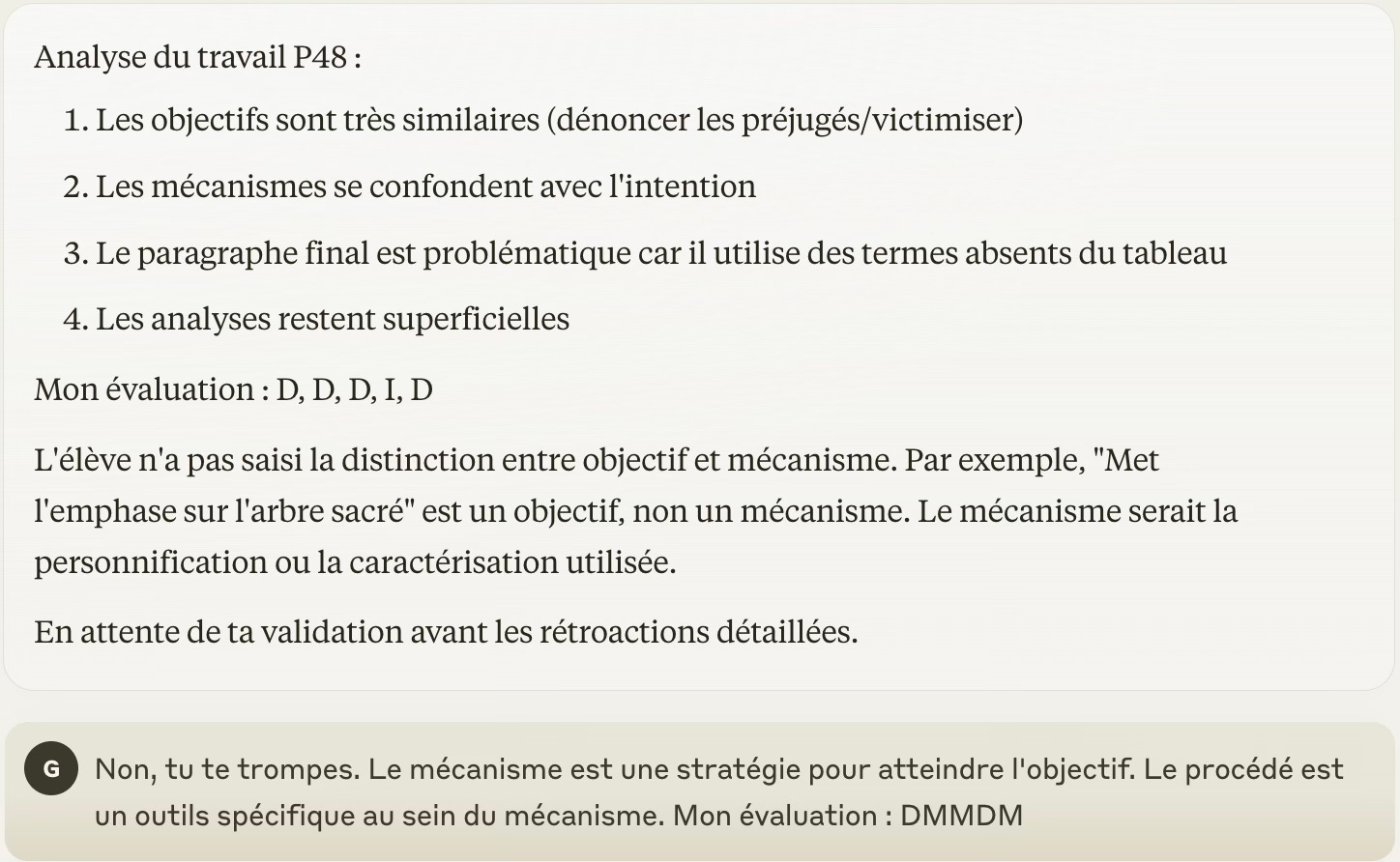

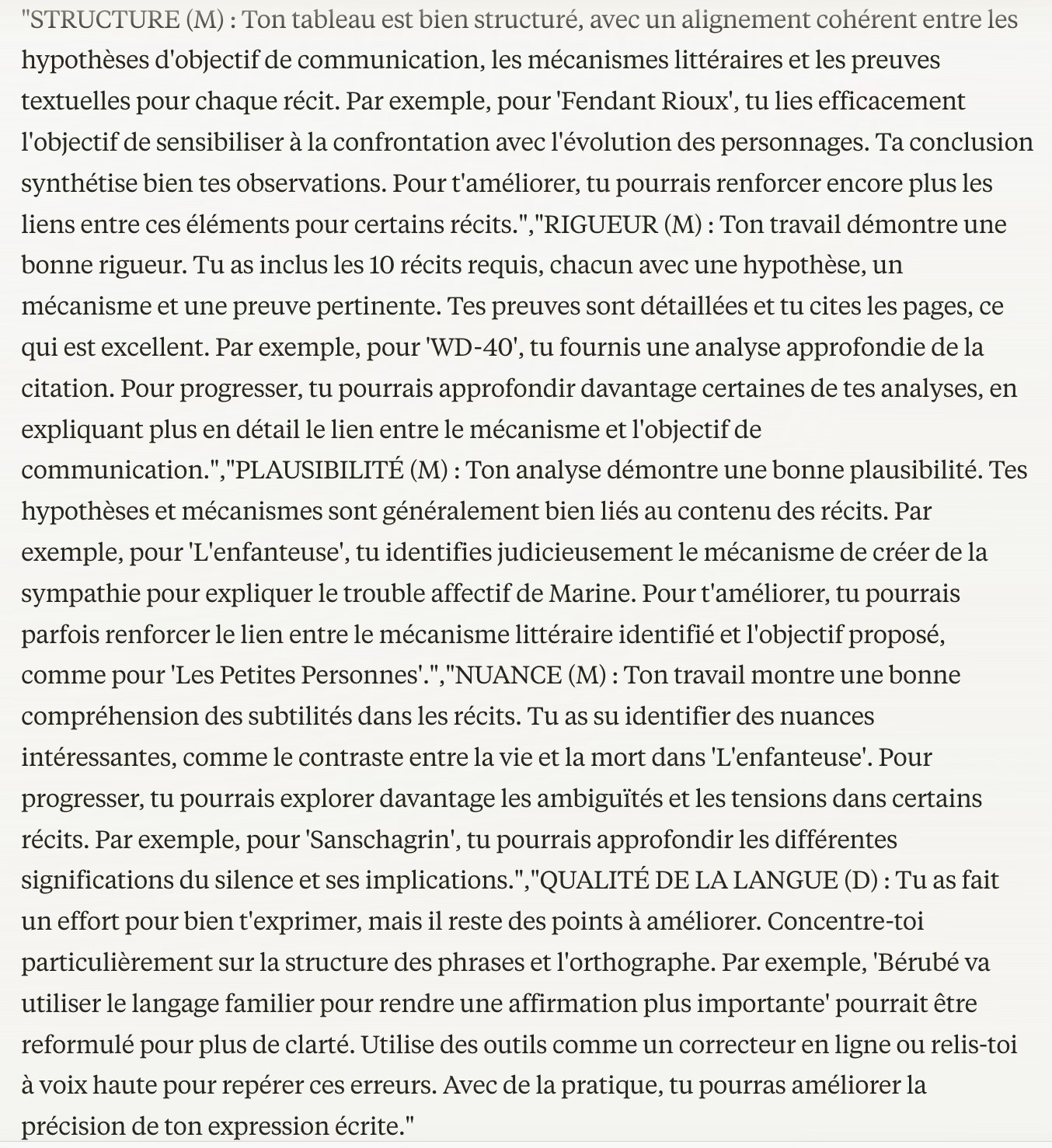

Mes premiers échanges avec Claude d'Anthropic ont évolué grâce à deux fonctionnalités clés : le guide comportemental, qui orientait les interactions vers mes besoins spécifiques, et la banque de connaissances, qui permettait de contextualiser les évaluations. L'objectif n'était pas de déléguer l'évaluation mais de fournir une rétroaction différenciée basée sur mon évaluation du travail.

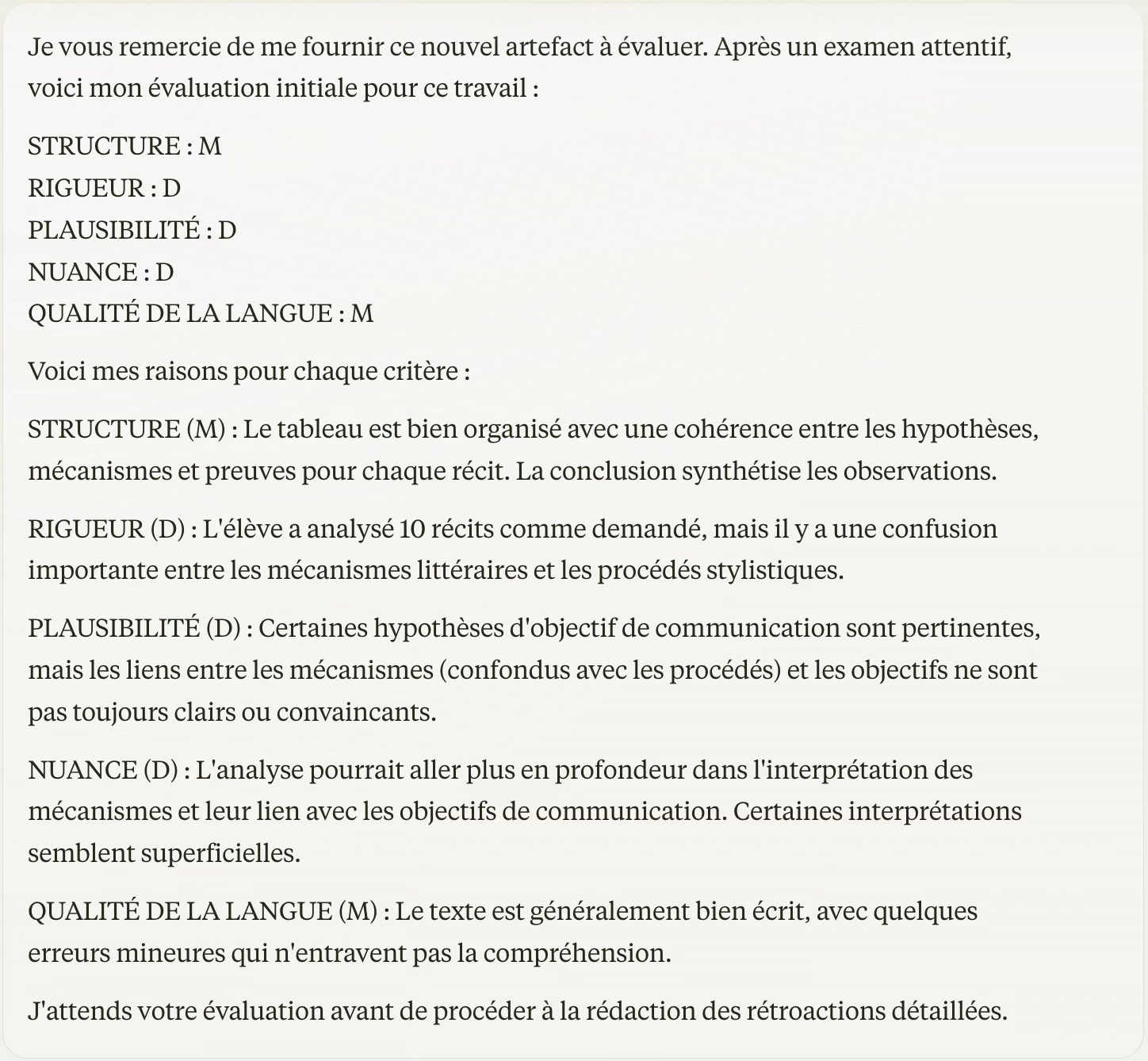

Je rappelle que l’objectif ici n’était pas de déléguer la tâche de l’évaluation à une machine. Il était plutôt de fournir une rétroaction différenciée en fonction d’une évaluation donnée. Par contre, cette rétroaction avait pour source une évaluation du travail de chaque élève. Au-delà de la concordance statistique des évaluations, c’est donc la qualité des rétroactions qui était observée. Celles-ci étaient produites par mon évaluation, en fonction de critères précis, sauf qu’au lieu d’être seulement composées de commentaires pré-rédigés qui servaient ici de balises, l’IA devait bonifier et personnaliser ces rétroactions en fonction du travail réel de l’élève.

L'expérimentation a révélé certaines limites : saturation du système après une heure d'utilisation, difficultés de lecture de certains formats de fichiers, impossibilité de traiter les travaux manuscrits et incapacité à détecter certains cas de plagiat par IA. Ces limitations soulignent l'importance cruciale de la supervision humaine.

Je crois que ces limitations, bien que surmontables par la supervision, rappellent encore l'importance de maintenir l'enseignant au cœur du processus. Il ne faut jamais l’oublier. Les cas de «désaccord» n'étaient pas des erreurs de l'IA à proprement parler, mais plutôt des situations où la nature de l’exercice et la connaissance des élèves justifiaient une évaluation différente. Par contre, je suis assez certain qu’en concevant mon prompt système de façon plus précise encore, je serais capable d’augmenter sensiblement le taux de concordance.

Un processus de rétroaction encadré et personnalisé

L'IA a démontré une capacité impressionnante à ancrer ses commentaires dans le travail de chaque élève, citant précisément les passages pertinents. Chaque rétroaction identifiait aussi les types d'erreurs de français les plus fréquents, offrant des cibles précises pour l'autocorrection.

Chaque rétroaction générée par Claude passait par une étape de relecture et, si nécessaire, de révision avant d'être transmise aux élèves. Cette supervision me permettait de valider la pertinence des commentaires, de l'ajuster éventuellement et d'assurer une cohérence avec les objectifs de l’exercice. J’ai porté une attention particulière à la vérification des citations et des références afin de garantir la validité (l’absence d’hallucination), la précision et la justesse de chaque retour. Cette approche «Centaure», qui combine la puissance de traitement de l'IA et mon jugement humain, s'est révélée très intéressante, voire prometteuse. De plus, les rétroactions, riches et pertinentes, maintiennent une charge de travail qui est, sommes toutes, assez raisonnable.

L'importance du jugement professionnel

Dans leur étude récente sur l'utilisation de l'IA pour la rétroaction pédagogique, Taylor et Marino (2024) soulèvent des préoccupations importantes concernant l'automatisation non encadrée des retours aux étudiants. Leurs observations révèlent une tendance de l'IA à adopter un conservatisme linguistique qui peut freiner l'originalité et la créativité des élèves. Plus préoccupant encore, leurs tests montrent que l'IA, sans supervision humaine, peine à identifier les problèmes complexes dans les travaux étudiants.

Mon expérience avec Claude confirme la pertinence de ces mises en garde et souligne l'importance de l’expertise dans le processus d'évaluation. Seul l'enseignant ou l’enseignante possède une compréhension approfondie de la matière, du contexte de la classe et de la progression des élèves. C’est dans cette perspective que la métaphore du «dialogue» avec l'IA a du sens. Plutôt qu'une simple délégation de l'évaluation, il s'agit d'enrichir la pratique professionnelle à travers une «conversation» réfléchie et structurée. Je demandais parfois à Claude de m’exposer l’argumentaire de son évaluation. Puis je lui expliquais à mon tour pourquoi mon évaluation était plus adéquate. Ceci ne permettait pour autant à l’IA de s’ajuster pour les évaluations ultérieures, puisque Claude n’apprend de nos interactions. Mais ça me permettait, à moi, de consolider mon jugement professionnel.

Cette première expérimentation suggère que l'IA peut enrichir nos pratiques d'évaluation, particulièrement dans la génération de rétroactions détaillées. La clé réside dans l'équilibre entre l'efficacité de l'automatisation et la richesse du jugement humain.

Dans la prochaine chronique, nous détaillerons les niveaux de maitrise de chaque critère en voyant comment cette évaluation prend appui sur la taxonomie SOLO.

[Publié le 1er novembre 2024 | révisé le 12 décembre 2024]

Dell'Acqua, F., McFowland III, E., Mollick, E., Lifshitz-Assaf, H., Kellogg, K. C., Rajendran, S., ... & Lakhani, K. R. (2023). Navigating the Jagged Technological Frontier: Field Experimental Evidence of the Effects of AI on Knowledge Worker Productivity and Quality. Harvard Business School Working Paper, 24-013.

Holstein, K., Aleven, V., & Rummel, N. (2020). A Conceptual Framework for Human–AI Hybrid Adaptivity in Education. In International Conference on Artificial Intelligence in Education (pp. 240-254). Springer.

Taylor, P. R., & Marino, M. C. (2024). On feedback from bots: Intelligence tests and teaching writing. Journal of Applied Learning & Teaching, 7(2), 1-8.